¡Tu carrito está actualmente vacío!

Investigadores del Reino Unido y Canadá han trabajado recientemente en la revista de acceso abierto arXiv advirtiendo sobre el ‘colapso del modelo’ a medida que la IA se entrena.

La rápida adopción de tecnologías como ChatGPT de OpenAI ha llevado a un aumento en el uso de IA generativa en los flujos de trabajo de muchas empresas.

Pero una vez que a mayor contenido generado por IA se difunde en Internet, surge la pregunta de cómo esto afectará a los modelos de IA entrenados.

Dichos expertos han profundizado este problema y encontraron que el uso de contenido generado por IA en el entrenamiento de modelos provoca defectos irreversibles en los modelos resultantes.

Este fenómeno conocido como «colapso del modelo», implica que los modelos distorsionan la realidad y pierden la capacidad de producir respuestas variadas y precisas.

Incluso cuando se entrenan para evitar respuestas repetitivas, los modelos comienzan a inventar respuestas erróneas para evitar la repetición excesiva de datos generados.

El problema se compara con la contaminación de los océanos con basura plástica y se destaca la dificultad de entrenar modelos nuevos a medida que se llena Internet con contenido de baja calidad.

Ted Chiang, escritor de ciencia ficción, también menciona que las copias de copias de IA resultarán en una degradación de la calidad, similar a los artefactos visibles en una imagen JPEG copiada repetidamente.

El colapso del modelo de IA es comparado con la contaminación

El equipo investigativo sugieren dos enfoques para evitar el colapso del modelo.

El primero implica conservar una copia del conjunto de datos original creado por humanos y evitar la contaminación con datos generados por IA.

El modelo se puede volver a entrenar periódicamente o desde cero con estos datos. El segundo enfoque es introducir conjuntos de datos nuevos y limpios generados por humanos en el entrenamiento de los modelos.

Si se hace este cambio, la implementación de estas soluciones requeriría un etiquetado masivo del contenido generado por IA y un esfuerzo por parte de las empresas y los creadores para diferenciar entre la información generada por IA y el generado por humanos.

Esto subraya la importancia de mantener una representación justa de grupos minoritarios en los conjuntos de datos para evitar la distorsión de la realidad.

También señalan que el problema del colapso del modelo requiere más investigaciones y estrategias para prevenirlo o manejarlo.

Aunque estos desafíos plantean preocupaciones para la IA generativa, se destaca que el contenido creado por humanos se volverá aún más valioso en el futuro como fuente de datos de entrenamiento confiables para la IA.

Los científicos proponen soluciones para evitar este problema y enfatizan la importancia de mantener la integridad de los modelos generativos a lo largo del tiempo.

Tagged in :

Más entradas

Wacom impulsa a Blender con gran donación

.

El fabricante japonés de tabletas gráficas Wacom ha dado un paso decisivo en el impulso del software de creación 3D de…

Nano Banana: Nueva forma en edición de imágenes de Google

.

Google ha dado un paso adelante en la edición de imágenes con IA gracias al lanzamiento de Gemini 2.5 Flash Image,…

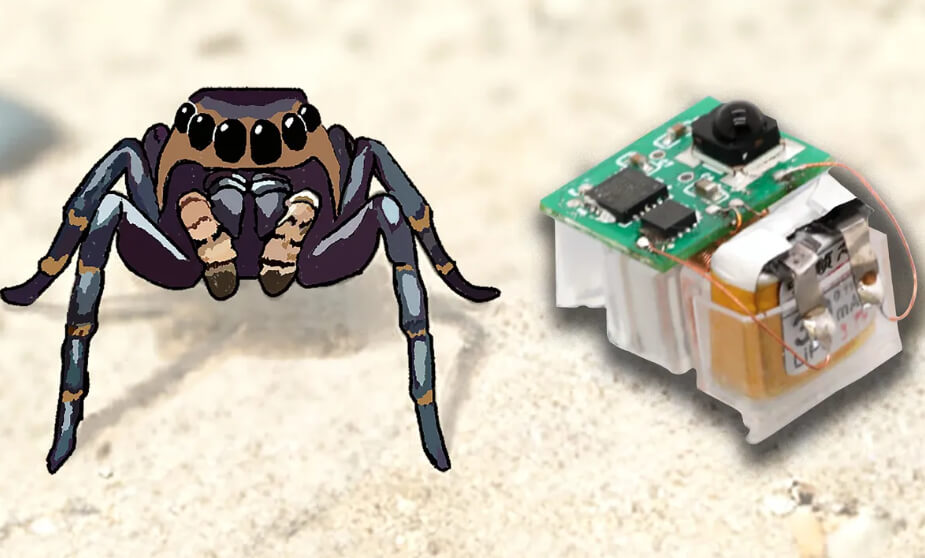

Actuadores flexibles dan agilidad a los robots insecto

.

Los robots insecto representan una alternativa para tareas de búsqueda y rescate, así como para la inspección de infraestructuras.