¡Tu carrito está actualmente vacío!

En el panorama actual de grandes modelos de lenguaje (LLM), ha surgido una nueva era de agentes inteligentes capaces de ejecutar tareas complejas.

Hoy hablaremos sobre un framework de agente multimodal basado en LLM diseñado para operar aplicaciones en teléfonos inteligentes.

Interacción humana simulada a través de espacios de acción simplificados

El marco permite a los agentes operar aplicaciones mediante un espacio de acción simplificado, imitando interacciones humanas como tocar y deslizar.

Esta aproximación elimina la necesidad de acceder al back-end del sistema, ampliando su aplicabilidad en diversas áreas.

Aprendizaje para navegar en aplicaciones móviles

El agente aprende a utilizar nuevas aplicaciones mediante exploración autónoma u observación de demostraciones humanas.

El proceso genera una base de conocimientos a la que la IA hace referencia para ejecutar tareas complejas en distintas aplicaciones.

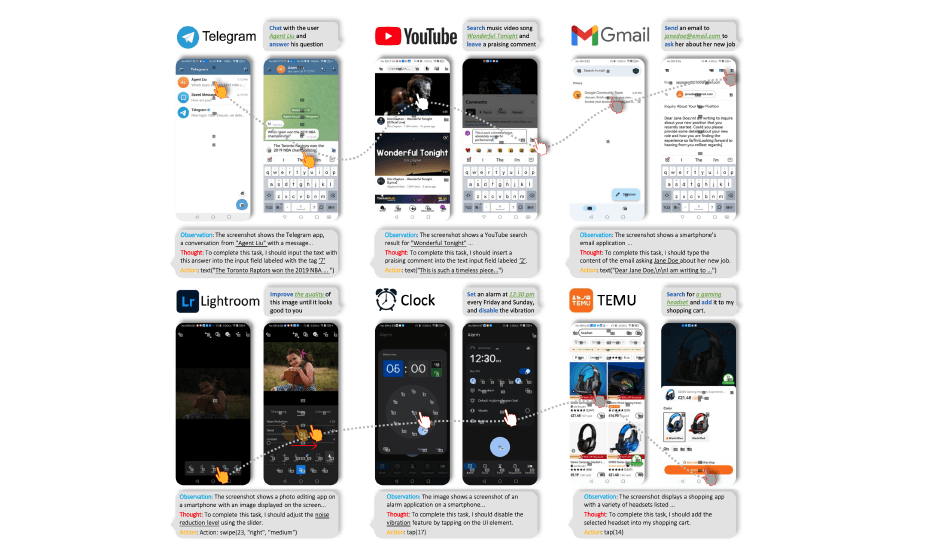

Pruebas exhaustivas: 50 tareas, 10 aplicaciones

Para validar la eficacia del agente, se llevaron a cabo pruebas en 50 tareas en 10 aplicaciones, abarcando desde redes sociales hasta sofisticadas herramientas de edición de imágenes. Los resultados confirman la competencia del agente en la ejecución de diversas tareas de alto nivel.

Demostración de capacidad de AppAgent

AppAgent, desarrollado por Grandes Modelos de Lenguaje, demuestra su capacidad para dominar y utilizar cualquier aplicación. Interactúa mediante gestos intuitivos, como tocar y deslizar, imitando acciones humanas para realizar tareas complejas.

Metodología de AppAgent: Fase de exploración y de implementación

El proceso de AppAgent se divide en dos fases: exploración e implementación. En la fase de exploración, el agente observa interacciones en interfaces de usuario, volviéndose experto en el uso de una aplicación. En la fase de implementación, el agente aplica este conocimiento para manejar tareas de alto nivel en cualquier aplicación compatible.

Enfoque de dos fases ilustrado

La figura ilustra las fases de exploración e implementación del marco. Tras la fase de exploración, el agente utiliza el conocimiento acumulado para operar y navegar eficientemente en aplicaciones.

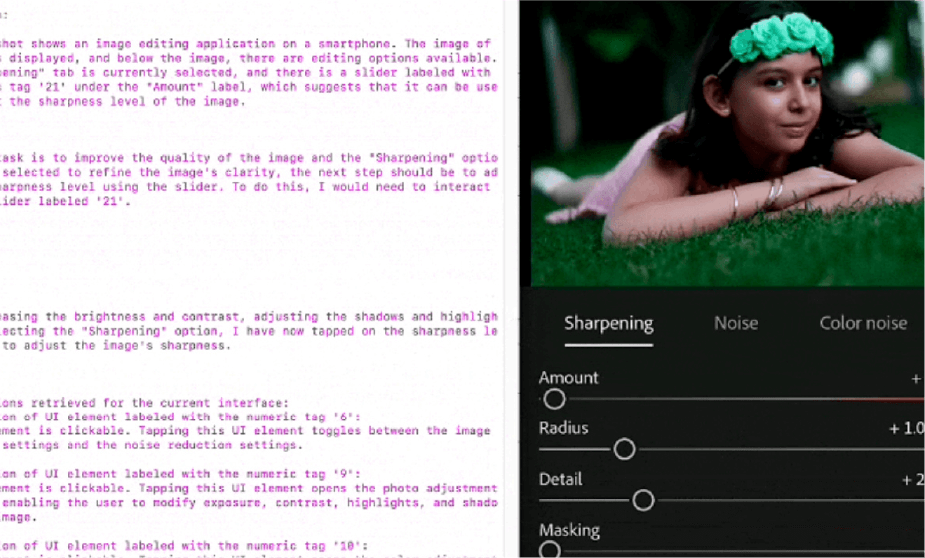

Profundo conocimiento de interfaz gráfica

AppAgent aprende la funcionalidad y lógica operativa de diversas aplicaciones al observar cambios en interfaces gráficas de usuario. Este conocimiento es crucial para su interacción inteligente con aplicaciones, permitiéndole adaptarse y completar tareas de manera eficiente.

Referencia a la base de conocimientos para tareas específicas

Ante una nueva interfaz, AppAgent hace referencia a su base de conocimientos para comprender su propósito y uso.

Luego, elabora una estrategia para realizar la tarea, ejecutando operaciones paso a paso con precisión.

AppAgent representa un hito en la interacción inteligente con aplicaciones móviles, destacando su capacidad para aprender y ejecutar tareas complejas en diversos contextos.

Tagged in :

Más entradas

IA y NASA: Predicción de eventos solares

.

La inteligencia artificial ayuda a predecir eventos solares y proteger satélites de posibles interrupciones.

Google renueva Play Store con IA y nuevas funciones

.

Google anunció una importante actualización de su Play Store, orientada a mejorar la interacción de sus más de 4 mil millones…