¡Tu carrito está actualmente vacío!

El uso masivo de programas automatizados para entrenar IA está afectando gravemente a repositorios científicos y revistas especializadas.

Ataques silenciosos a portales académicos

En febrero, el sitio DiscoverLife, que alberga cerca de tres millones de imágenes de especies, comenzó a recibir millones de visitas diarias.

El tráfico anómalo, causado por bots automatizados, llegó a ralentizar la plataforma hasta volverla inoperante.

Dicho fenómeno no es aislado: diversas revistas científicas y bases de datos están sufriendo interrupciones por el creciente uso de bots que extraen información sin permiso.

Bots generativos: una nueva amenaza para los sitios web científicos

El auge de los modelos de inteligencia artificial generativa ha impulsado el uso de «web scrapers», programas que recopilan grandes volúmenes de contenido para alimentar modelos como los chatbots y generadores de imágenes.

Los bots suelen operar desde direcciones IP anónimas, dificultando su bloqueo.

A diferencia de los rastreadores comunes, su comportamiento es mucho más agresivo y dañino para los sitios web.

Impacto directo en la investigación científica

Organizaciones como BMJ, editorial médica con sede en Londres, han registrado más tráfico de bots que de usuarios legítimos.

La problemática provoca sobrecargas en sus servidores y caídas del sistema. Lo mismo ha ocurrido con Highwire Press y otros servicios especializados en publicaciones científicas.

En muchos casos, los investigadores y lectores encuentran interrumpido su acceso a información crucial.

Preocupación en la comunidad científica

La Confederación de Repositorios de Acceso Abierto (COAR) reportó en abril que más del 90 % de sus miembros fue víctima de bots de IA.

Dos tercios experimentaron interrupciones graves. Aunque estos repositorios son de acceso abierto, la extracción masiva y sin control está provocando problemas operativos serios.

Una carrera por los datos de entrenamiento

El auge de modelos como DeepSeek, desarrollado en China, ha acelerado esta tendencia. Al demostrar que es posible entrenar modelos avanzados con menos recursos, aumentó la presión por conseguir datos masivos.

Esto ha desatado una competencia que, sin regulación, pone en riesgo la estabilidad de las plataformas científicas.

Con información de Nature.

Tagged in :

Más entradas

Nano Banana: Nueva forma en edición de imágenes de Google

.

Google ha dado un paso adelante en la edición de imágenes con IA gracias al lanzamiento de Gemini 2.5 Flash Image,…

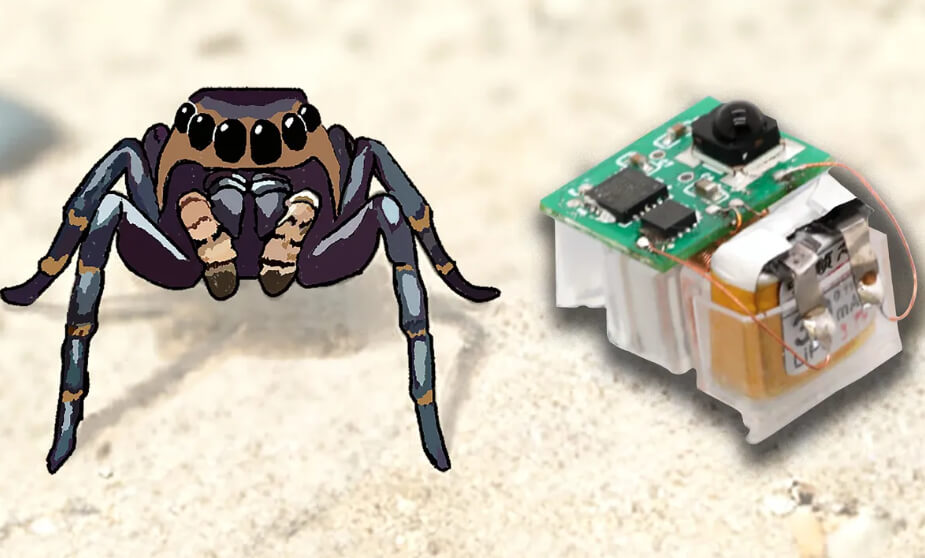

Actuadores flexibles dan agilidad a los robots insecto

.

Los robots insecto representan una alternativa para tareas de búsqueda y rescate, así como para la inspección de infraestructuras.

Genie 3: Nuevo avance en mundos virtuales

.

DeepMind ha presentado Genie 3, un modelo de “world model” que puede generar entornos 3D interactivos en tiempo real a partir…