¡Tu carrito está actualmente vacío!

El CTO de Microsoft, Kevin Scott, sigue convencido de que las «leyes de escalado» de los modelos de lenguaje grande (LLM) continuarán impulsando el progreso de la inteligencia artificial, a pesar de las críticas que sugieren que el avance se ha ralentizado.

En una entrevista reciente con el podcast Training Data de Sequoia Capital, Scott defendió la idea de que el rendimiento de los modelos mejora con el incremento de la computación, los datos y el tamaño de los modelos.

Apuesta por el progreso continuo

Scott, quien jugó un papel clave en el acuerdo de 13,000 millones de dólares entre Microsoft y OpenAI, afirmó que no estamos en una fase de rendimientos decrecientes.

Según él, el progreso exponencial puede verificarse cada dos años debido al tiempo que lleva construir supercomputadoras y entrenar modelos en ellas.

Las leyes de escalado, propuestas por OpenAI en 2020, sostienen que los LLM mejoran predictiblemente con más parámetros, datos y computación, sin necesidad de avances algorítmicos fundamentales.

¿Seguirán mejorando los LLM con más computación?

Algunos investigadores cuestionan la persistencia de estas leyes a largo plazo.

Críticos en la comunidad de IA han sugerido que el progreso se ha estancado, señalando que modelos recientes como Gemini 1.5 Pro de Google y Claude Opus de Anthropic no han mostrado mejoras notables respecto a generaciones anteriores.

Gary Marcus, un crítico de IA, ha cuestionado la falta de avances dramáticos desde GPT-4.

La «leyes de escalado» impulsa las LLM

Scott sostiene que las inversiones en LLM más grandes son justificadas, apostando por avances continuos.

Ed Zitron, otro crítico frecuente, argumenta que OpenAI podría estar ocultando una tecnología revolucionaria.

La percepción de una ralentización podría deberse a la rápida aparición de la IA en el ojo público, cuando en realidad los LLM llevan años en desarrollo.

En la entrevista, Scott rechazó la idea de que el progreso se haya estancado, aunque reconoció los desafíos de evaluar los avances debido a los puntos de datos poco frecuentes.

Aseguró que futuras iteraciones mostrarán mejoras, particularmente en áreas donde los modelos actuales son frágiles, prometiendo una IA más barata y robusta en el futuro.

Con información de Ars Technica.

Tagged in :

Más entradas

Nano Banana: Nueva forma en edición de imágenes de Google

.

Google ha dado un paso adelante en la edición de imágenes con IA gracias al lanzamiento de Gemini 2.5 Flash Image,…

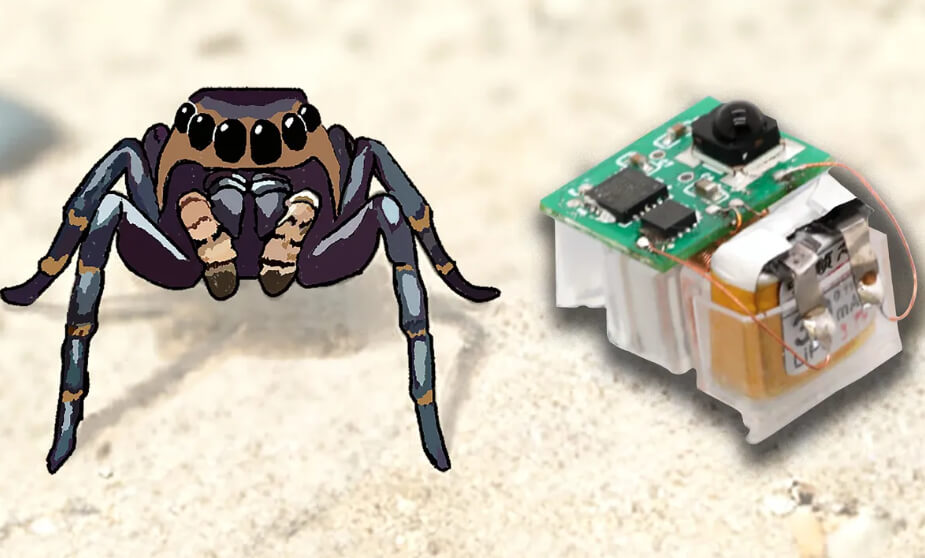

Actuadores flexibles dan agilidad a los robots insecto

.

Los robots insecto representan una alternativa para tareas de búsqueda y rescate, así como para la inspección de infraestructuras.

Genie 3: Nuevo avance en mundos virtuales

.

DeepMind ha presentado Genie 3, un modelo de “world model” que puede generar entornos 3D interactivos en tiempo real a partir…