¡Tu carrito está actualmente vacío!

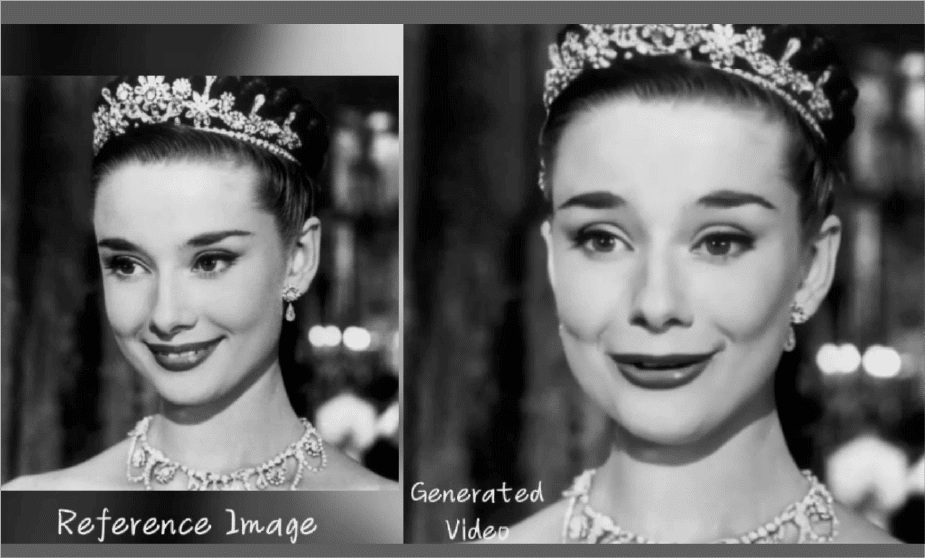

Los investigadores del Instituto de Computación Inteligente del Grupo Alibaba presentan EMO (Emote Portrait Alive), un framework de trabajo para generar videos de retratos expresivos a partir de una sola imagen de referencia y un audio vocal.

Este framework trabaja a partir de imágenes realizando videos expresivos generando retratos y videos basado en audio.

El proceso consta de dos etapas: codificación de fotogramas y difusión. Mecanismos como Referencia-Atención y Audio-Atención preservan la identidad y modulan los movimientos del personaje.

Visión general de EMO

EMO se constituye principalmente en dos etapas. En la fase inicial, denominada codificación de fotogramas, ReferenceNet se despliega para extraer entidades de la imagen de referencia y de los fotogramas de movimiento.

Posteriormente, durante la etapa del proceso de difusión, un codificador de audio previamente entrenado procesa la incrustación de audio.

La máscara de la región facial está integrada con ruido de varios fotogramas para controlar la generación de imágenes faciales.

A esto le sigue el empleo de la red troncal para facilitar la operación de eliminación de ruido. Dentro de la Red Troncal se aplican dos formas de mecanismos de atención:

Referencia-Atención y Audio-Atención. Estos mecanismos son esenciales para preservar la identidad del personaje y modular sus movimientos, respectivamente.

Además los módulos temporales se utilizan para manipular la dimensión temporal y ajustar la velocidad del movimiento.

Hacer que el retrato cante

Al momento de introducir una imagen de un solo personaje y un audio vocal, como cantando, EMO puede generar videos de avatares vocales con expresiones faciales expresivas y varias poses de la cabeza.

Por lo tanto se puede generar vídeos con cualquier duración dependiendo del audio de entrada.

El modelo también puede persistir las identificaciones de los caracteres en un período prolongado.

Diferente lenguaje y estilo de retrato

EMO admite canciones en varios idiomas y da vida a diversos estilos de retratos.

Reconoce intuitivamente las variaciones tonales en el audio, lo que permite la generación de avatares ricos en expresiones.

Ritmo rápido

El avatar impulsado puede seguir el ritmo de los ritmos rápidos, garantizando que incluso las letras más rápidas estén sincronizadas con la expresividad y el dinamismo de las animaciones de personajes.

Hablar con diferentes personajes

El enfoque no se limita a procesar las entradas de audio del canto, sino que también puede adaptarse a las habladas audio en varios idiomas.

De igual modo, cuenta con la capacidad de animar retratos de épocas pasadas, pinturas, y tanto los modelos 3D como el contenido generado por IA, infunde movimiento y realismo.

EMO posibilita la creación de imágenes estáticas y animarlas a partir del audio y de lo que dependa su duración, aplicado a diferentes contextos, lenguas y funcionalidades.

Estos mecanismos son esenciales para preservar la identidad del personaje y modular sus movimientos, respectivamente.

Tagged in :

Más entradas

Wacom impulsa a Blender con gran donación

.

El fabricante japonés de tabletas gráficas Wacom ha dado un paso decisivo en el impulso del software de creación 3D de…

Nano Banana: Nueva forma en edición de imágenes de Google

.

Google ha dado un paso adelante en la edición de imágenes con IA gracias al lanzamiento de Gemini 2.5 Flash Image,…

Actuadores flexibles dan agilidad a los robots insecto

.

Los robots insecto representan una alternativa para tareas de búsqueda y rescate, así como para la inspección de infraestructuras.