¡Tu carrito está actualmente vacío!

Vid2Avatar es un método para aprender avatares humanos a partir de videos monoculares en entornos naturales.

La reconstrucción de humanos en movimiento desde videos monoculares es un desafío considerable que implica separar con precisión los sujetos del fondo arbitrario y reconstruir una superficie 3D detallada.

Desafíos superados

A diferencia de enfoques anteriores, Vid2Avatar no requiere supervisión de la realidad del terreno ni datos de escaneos humanos vestidos.

Tampoco depende de módulos de segmentación externos.

El método resuelve la descomposición de la escena y la reconstrucción de la superficie en 3D modelando tanto al humano como al fondo simultáneamente.

Metodología de Vid2Avatar

Se utiliza una representación humana temporalmente consistente en el espacio canónico.

La optimización global se realiza sobre el modelo de fondo, la forma y textura humana canónica, y los parámetros de pose humana por fotograma.

La estrategia de muestreo de grueso a fino garantiza una separación limpia del fondo humano y estático dinámico, logrando reconstrucciones detalladas y robustas en 3D.

Reconstrucción de avatares neuronales implícitos:

Vid2Avatar resuelve tareas de descomposición de escenas y reconstrucción de superficies directamente en 3D, a diferencia de métodos anteriores que dependen de herramientas de segmentación 2D o máscaras etiquetadas manualmente.

La representación implícita de humano y fondo, parametrizada por campos neuronales separados, se aprende conjuntamente de las imágenes para componer la escena completa.

Comparación y resultados:

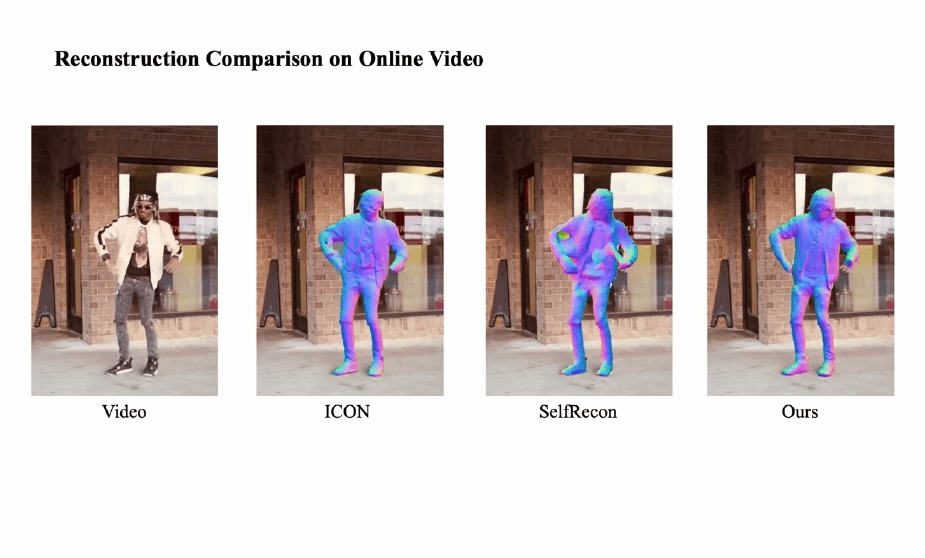

El método supera a las técnicas existentes gracias al desacoplamiento superior de humanos y fondo en la descomposición de la escena auto-supervisada.

Vid2Avatar demuestra una notable capacidad de generalización a diferentes formas humanas, estilos de ropa y rasgos faciales, incluso en poses desafiantes y entornos complicados.

Visualización y conjunto de datos SynWild:

La reconstrucción en 3D resultante puede visualizarse desde cualquier ángulo. Además, se introduce el conjunto de datos SynWild, creado para evaluar la reconstrucción de la superficie humana a partir de videos monoculares en la naturaleza.

Reconocimientos

Chen Guo recibió el respaldo de la beca del JRC suizo de Microsoft Research, mientras que Xu Chen contó con el apoyo del Centro Max Planck ETH para Sistemas de Aprendizaje.

Tagged in :

Más entradas

IA y NASA: Predicción de eventos solares

.

La inteligencia artificial ayuda a predecir eventos solares y proteger satélites de posibles interrupciones.

Google renueva Play Store con IA y nuevas funciones

.

Google anunció una importante actualización de su Play Store, orientada a mejorar la interacción de sus más de 4 mil millones…